Big data es un término que hace referencia al conjunto de datos y sus combinaciones, cuyo volumen, complejidad y velocidad de crecimiento hacen que no sea posible su captura, gestión, procesamiento o análisis con tecnologías convencionales. La recopilación de esas grandes cantidades de datos y el estudio de tendencias se hace mediante algoritmos que permiten predecir con altos grados de certeza lo que ocurrirá y, a partir de eso, tomar decisiones. El análisis de big data es un recurso que se puede aplicar en cualquier tipo de empresas o instituciones. Por ejemplo, en un hospital en medio de una pandemia.

La empresa RockingData trabajó en conjunto con profesionales de la terapia intensiva de un sanatorio privado de Buenos Aires —el nombre se mantiene en reserva— para organizar el enorme volumen de datos disponible, establecer patrones y prever cosas como cuántas camas debían tener libres, cuántos insumos eran necesarios, cómo ordenar y planificar los descansos de los médicos y —sobre todo— cuántas personas iban a ingresar con COVID-19 a terapia intensiva.

En los modelos que estructuran este tipo de proyectos residen algoritmos inteligentes que son capaces de encontrar patrones y de hacer predicciones o de modificarse, en caso de que la tendencia cambie. “El análisis de los datos otorga previsibilidades y respuestas a las preguntas que nos hacemos en estas circunstancias”, dice Fredi Vivas, CEO de RockingData. La ciencia de datos se basa en saber qué pasó para predecir qué puede ocurrir.

“Son herramientas, modelos predictivos que analizan, predicen y aprenden mediante los ejemplos. Cuantos más casos de análisis tengan, más precisión se conseguirá”, agrega Vivas, quien también se desempeña como coordinador académico del Programa Big Data de la Universidad de San Andrés y este año publicará su primer libro: ¿Cómo piensan las máquinas?, que terminó de escribir en mayo pasado y que nació cuando él mismo tuvo COVID-19 en 2020.

TAMBIÉN PODÉS LEER

“Con la incorporación de más y más datos, la máquina encuentra sola las reglas para analizarlos”, agrega. De este modo, a través del algoritmo de predicción de la demanda, el sanatorio logró anticiparse al alto volumen de pacientes que recibió el sector de terapia intensiva. Además, permitió tomar decisiones estratégicas basadas en datos para determinar los turnos y rotación de personal y, así, cubrir de manera más segura y efectiva la situación generada por la pandemia.

La predicción de la demanda está centrada en el machine learning, un concepto que en su traducción al español tiene tres acepciones: aprendizaje automático, aprendizaje automatizado o aprendizaje de máquinas. El objetivo de Vivas y su compañía es desarrollar técnicas que permitan que las computadoras aprendan. Una obsesión y una pasión en las que aplica y combina el periodismo, la narrativa, la ciencia ficción y su profesión de ingeniero en sistemas.

Un presagio

“No hay tanto material en español sobre big data. Usé un lenguaje llano para que todos lo pudieran leer y entender. Hacía tiempo que quería escribir un libro, pero no me enamoraba ninguna idea, hasta que en septiembre del año pasado tuve COVID-19. Un día que estuve con mucha fiebre, me quedé dormido y soñé que miraba la calle desde mi ventana y veía todo prendido fuego”, repasa Vivas los detalles de esta escena.

En el sueño, mientras contempla la destrucción total, Fredi ve que unas máquinas que emulan el aspecto de los humanos están recorriendo el barrio. “Estoy sorprendido, mirando lo que ocurre, cuando se me acerca un hombre que se parece al personaje de Terminator 4 y me dice: ‘Fredi, te trajimos acá porque te necesitamos, vos entendés cómo piensan las máquinas’”. En ese momento Vivas se despertó, entre los dolores del cuerpo, las altas temperaturas y la inspiración y empezó a tramar una historia que introduce en la ficción los detalles del trabajo que junto a su equipo realizan a diario en la empresa.

El desafío y la solución

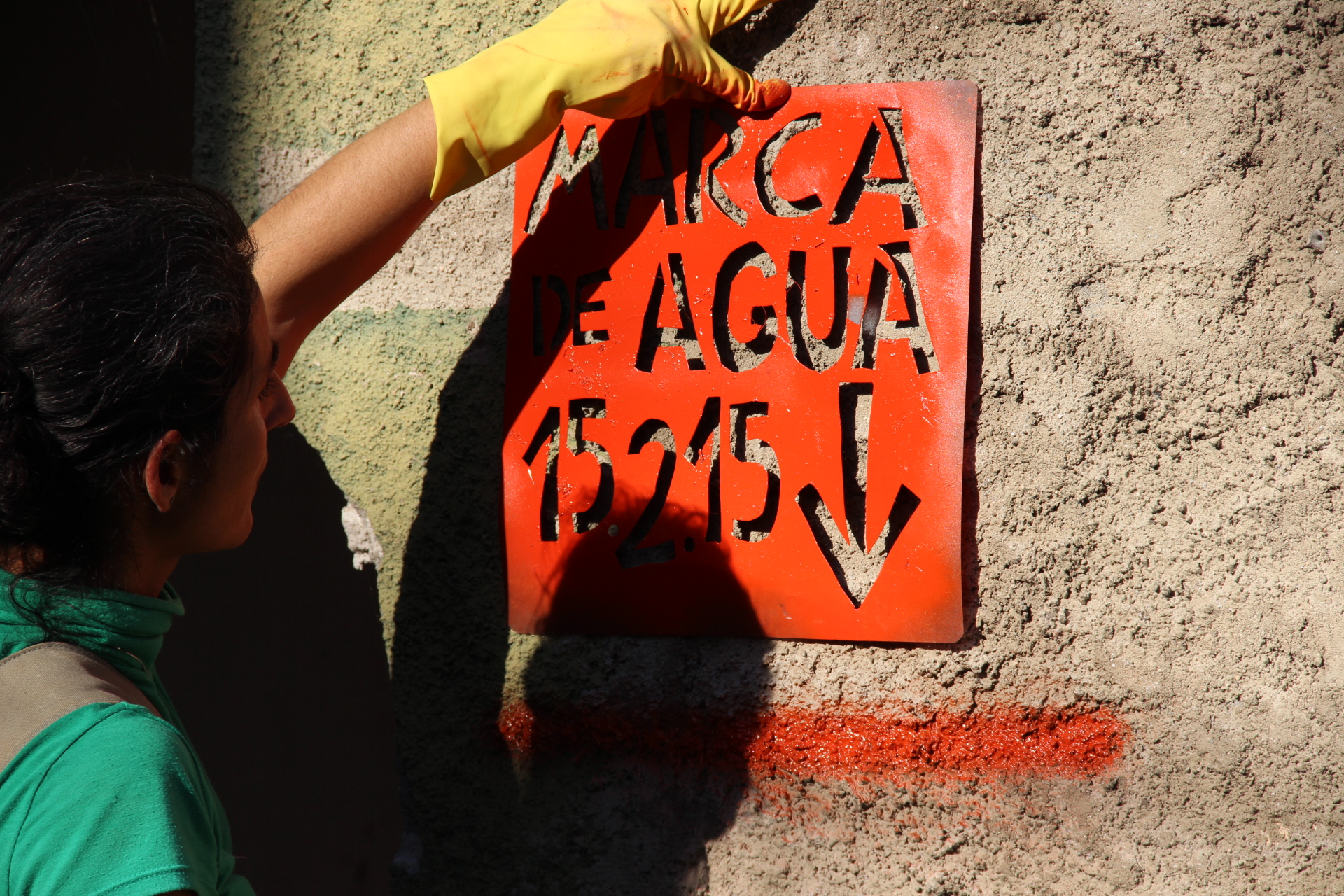

Cuando los integrantes de RockingData fueron convocados por las autoridades de la terapia intensiva del sanatorio tuvieron un desafío claro: el algoritmo debía predecir cuántas personas ingresarían con la patología COVID-19 en los siguientes 15 días.

En la Argentina se transitaba aún la primera ola de la pandemia. La herramienta debía ser de máxima utilidad para tomar decisiones estratégicas. El algoritmo de predicción se basó en la información sobre los pacientes que todavía estaban en el sanatorio y los dados de alta, empleados y datos históricos del sanatorio. A partir de esa base “pudo entrenarse y aprender de las curvas de todo el año”, describen en RockingData. De este modo, se logró determinar que para fines de abril o comienzos de mayo de este año se iba a producir una situación parecida a la de junio o julio de 2020, cuando se generó un pico de ingresos.

Según Vivas, se obtuvo más de un 85 por ciento de precisión en la predicción de la demanda . “Con la implementación de este algoritmo el sanatorio pudo prever con dos semanas de anticipación el volumen de trabajo que tendría y, por lo tanto, qué recursos necesitaría —camas, refuerzo de personal, etc.— para afrontar el aumento de casos”, agregó.

El diseño del algoritmo se enriqueció con las estadísticas nacionales y, a fines de 2020, llegó a tener un ciento por ciento de precisión en las predicciones. “Los algoritmos necesitan un tiempo de aprendizaje. Nosotros trabajamos en el nuestro tres meses antes de que sirviera para la toma de decisiones sobre la gestión, organización y mejora en la capacidad de servicio del sanatorio”, agrega Vivas.

La calidad en los datos

Si bien desde comienzos de la pandemia muchas instituciones se pusieron en contacto con esta empresa, en un principio la calidad de los datos que se manejaban no era buena. “La data no era suficiente, ni veraz, ni existía calidad para tener predicción. No tenía sentido trabajar así, hubiera sido una irresponsabilidad de nuestra parte”, dice Vivas.

Cuando habla de la calidad de los datos se refiere a que en los albores de la pandemia existía demasiada información trunca, había registros sin completar, no se sabía cuáles eran los síntomas de los pacientes o faltaban las fechas de los ingresos en los hospitales. “Hay mecanismos para mejorar la calidad. Pero, por ejemplo, en muchos lugares la información estaba solo en papel y eso hace que no sea fiable, a lo que se suman los errores que puedan surgir en la carga de datos”, agrega.

Lo que Vivas denomina “huecos en la información” se puede cubrir con técnicas de mejora en la carga, aunque en algunas circunstancias es demasiado complejo. Para que se produzca un cambio real, sostiene, es necesario que toda la sociedad esté atravesada por una apertura de datos.

TAMBIÉN PODÉS LEER

“Hay que abrir los datos, eso le otorga transparencia a la gestión. Hay poca gente que se pone a explorar la información que ya existe. Es necesario abrir más y más para tomar decisiones basadas en los datos”. Y para graficar lo que significaría esto para la sociedad, Vivas recurre a la figura de un “ciudadano científico”.

“Un ciudadano científico sería aquel que pudiera explorar sobre algo, aunque no tuviera el bagaje teórico o no fuera profesional, pero que en esa exploración, en esa ciudadanía científica obtuviera un saber que le permitiera ser un líder en la toma de decisiones. Es un rol que no está desarrollado”, describe.

El ciudadano científico debería desarrollar la capacidad de tomar decisiones basadas en los datos más que en la intuición. “Es necesario cambiar la sociedad. Hay que modificar la organización en la gestión de procesos que hoy nos dan mucha incertidumbre. El ciudadano, el paciente, el alumno deberían estar al frente de la gestión si los datos fueran abiertos”, agrega Vivas, quien sostiene que la tecnología bien usada y puesta al servicio de la gente es también una forma de humanizar la sociedad.

***

Esta nota forma parte de la plataforma Soluciones para América Latina, una alianza entre INFOBAE y RED/ACCIÓN, y fue publicada originalmente el 30 de junio de 2021.

Podés leer este contenido gracias a cientos de lectores que con su apoyo mensual sostienen nuestro periodismo humano ✊. Bancá un periodismo abierto, participativo y constructivo: sumate como miembro co-responsable.