En uno de los episodios de la serie británica Black Mirror, titulado “Hated in the Nation” (“Odio nacional”), dos detectives investigan las repentinas muertes de diferentes personas con un punto en común: todas habían sido blanco de ataques masivos en redes sociales. Más específicamente: las víctimas, que habían hecho o dicho algo que había provocado un repudio generalizado, habían ganado sin saberlo una suerte de juego que indicaba que quien recibiera, diariamente, la mayor cantidad de tuits con el hashtag “#DeathTo” (“#MuerteA”) sería asesinado.

Aunque la serie estuvo disponible en Netflix en 2016, las primeras dos temporadas se estrenaron en 2011. Es decir: hace una década, cuando todavía no hablábamos de trolls ni de violencia en línea, alguien ya pensaba que las redes sociales podrían ser un espacio que amplificara los discursos de odio y los ataques colectivos. Y que podía salirse de control. Diez años después, la violencia de género en línea y las agresiones en masa son cotidianas y van desde ataques a mujeres con voces y presencias fuertes en el debate público (activistas, periodistas, políticas) hasta las violencias que pueden darse en los vínculos virtuales: sextorsión (chantajear a alguien con difundir imágenes íntimas), cyber flashing (enviar fotos obscenas sin consentimiento), hacer público material privado y más. Si bien son situaciones que padecen tanto mujeres como varones, las consecuencias no son iguales para unas y otros. Como tampoco lo son, en muchos casos, la dimensión, la coordinación y la sistematicidad. Así es que estos ataques dirigidos a mujeres son tipificados como otro tipo de violencia de género.

Por este motivo y luego de estudios, advertencias y pedidos de organizaciones locales e internacionales, las plataformas como Twitter y Meta (Facebook, Instagram) están renovando sus herramientas, tanto para que las mujeres afectadas puedan protegerse como para educar a los usuarios en general, que tomen conciencia del problema. Alertar cuando se está difundiendo un mensaje de odio, detectar ataques masivos, brindar herramientas para prevenir que se publiquen materiales íntimos son algunas.

TAMBIÉN PODÉS LEER

El diagnóstico

Para la abogada especializada en derecho informático Marina Benítez Demtschenko —quien también preside la Fundación Activismo Feminista Digital, desde donde promueve el reconocimiento de los derechos digitales con perspectiva de género— la violencia digital “tiene que ver con lo digital y con la conectividad. Y la conectividad es muy amplia. No es solamente ‘difundieron mis fotos’, también se vincula a todos los equipos que no estamos resguardando debidamente. Recibo trillones de consultas semanales sobre múltiples situaciones que además del celular y la computadora incluyen routers, módems, smart tvs. Ampliar la concepción de violencia digital a posibles accesos indebidos a otros equipos es muy común”. “Una de las primeras preguntas que suelen venir de la mano de las consultas es ‘¿Qué hago?, ¿denuncio? ¿Cómo abordo esto?’”, cuenta la abogada.

En opinión de Demtschenko, el gran problema al enfrentar estos ataques es el desconocimiento que “va de la mano con la falta de alfabetización digital que tenemos en la Argentina y en la región”. Y esa falta de conocimiento, se combina con la brecha digital de género: “Hay una desigualdad estructural en materia de uso, aprovechamiento, acceso a las tecnologías de la comunicación y la información. Razón por la cual tenemos mucho menos conocimiento de cómo manipularlas, cómo estar seguras, cómo ejercer nuestra autodeterminación informativa. A lo que se le suma la violencia machista. Confluyen estas dos cuestiones que son preocupantes”, señala.

La Asociación Civil Comunicación para la Igualdad, que trabaja para promover “la igualdad y diversidad de género en la comunicación” realizó en 2020 la investigación ¿Es posible debatir en medio de discursos de odio?, en la que analizó cuentas de Twitter de la Argentina, Chile, Paraguay y Uruguay, para detectar “acciones estigmatizantes y discriminatorias, que por violentas, acallan voces y empobrecen el debate público en torno a la agenda de la igualdad de género”.

Sandra Chaher, presidenta de la asociación, dice que con la pandemia la violencia en redes se agravó, principalmente en los posteos vinculados a la agenda de género. Por eso, el equipo de Comunicación para la Igualdad quiso ver qué estaba pasando con las activistas feministas. Anteriormente había hecho otra investigación para estudiar la violencia digital hacia mujeres periodistas en América Latina.

Lo que encontró en este segundo estudio fue que la Argentina fue el país donde más creció la violencia de género en línea y, como consecuencia, donde menos intercambio hubo entre activistas del movimiento de mujeres y grupos antigénero. Una de las principales conclusiones indica que la violencia causa que cada sector se cierre sobre sí mismo y dialogue únicamente con quienes tienen ideas afines, dado que las agresiones y mensajes ofensivos solo conducen al bloqueo de quienes piensan diferente y no a una instancia de debate o intercambio.

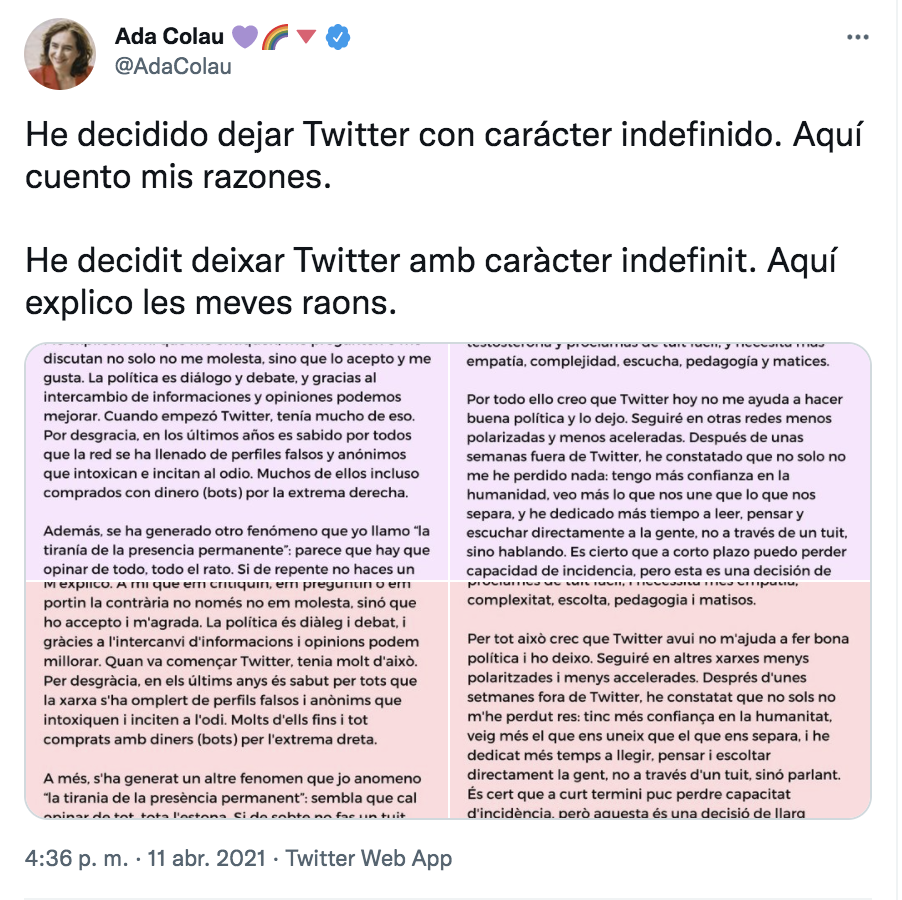

Una consecuencia habitual es la retirada. La alcaldesa de Barcelona Ada Colau, por ejemplo, anunció en abril pasado que se retiraba de Twitter por los términos en que se estaba dando la discusión política y el tenor de los discursos de odio. Esto último retiró de Twitter por unos cuantos meses a la legisladora porteña Ofelia Fernández.

“En general, lo que nosotras detectamos, tanto en esta investigación de discursos de odio como en la de agresiones a periodistas feministas es que a partir de estos ataques las mujeres están retirándose del debate público total o parcialmente, porque además no todas pueden tramitarlos emocionalmente de la misma manera. Algunas mujeres tienen una resistencia enorme. Otras terminan en terapia. Hay casos recolectados por Amnistía Internacional que terminan en intentos de suicidio. Nosotras no nos encontramos con ninguno así, pero en el informe Toxic Twitter, que es un estudio global de Amnistía, sí los hay”, dice Chaher.

Otro dato que destaca es que más del 40 % de las mujeres entrevistadas en sus investigaciones asegura que las agresiones que comienzan en las redes escalan a canales virtuales más personales, como el mail o el Whatsapp, e incluso llegan a ataques físicos en la calle.

Qué hacen las plataformas

Tanto Chaher como Demtschenko señalan que las empresas detrás de las redes son conscientes de esta situación e intentan —con más o menos efectividad— sumar nuevas medidas para combatirla.

“Twitter ha tenido iniciativas muy interesantes en el último año y medio. Los reportes los atienden con urgencia, propician un entorno mucho más afable para que podamos desenvolvernos libremente, repudian y toman acción directa contra los ataques, tienen respuestas bastante rápidas. Se preocupan muchísimo por mejorar los formularios de denuncia, especializar a los equipos humanos que están interviniendo en las que llegan —que son millones por día— y tienen reuniones regulares con organizaciones de la sociedad civil para entender y ver qué se necesita, cómo reforzar las medidas”, enumera Demtschenko.

Chaher también cuenta que luego de la primera investigación que realizó la asociación que preside, Twitter ofreció un espacio de encuentro y un taller sobre seguridad.

“En el encuentro les preguntamos por qué, si nosotras habíamos podido identificar cuentas [que realizaban ataques], sabiendo a qué redes pertenecían y a quiénes estaban vinculadas políticamente, Twitter no lo hacía. O por qué no actuaban frente a acciones coordinadas como son esos ataques que en 24 horas envían 500 posteos violentos. Y el argumento, en general, es el de la libertad de expresión”, dice.

En las investigaciones de Comunicación para la Igualdad, cuando se preguntó a las personas si habían denunciado los ataques y si estaban conformes respecto de cómo habían respondido las redes, las respuestas fueron en su mayoría negativas: “Poca gente dice que está satisfecha con la respuesta que le dio una red social. O no les contestaron o les contestaron tarde. En la mayoría de los casos las mujeres cuentan que hicieron una denuncia por un ataque y nunca tuvieron respuesta”.

Aún así, Chaher reconoce la dificultad que tienen las plataformas para hacer frente a esto y las estrategias que aplican para mejorar. “Toman medidas y de hecho todo el tiempo están sacando nuevas. Hay una preocupación en las redes en relación a los discursos de odio. Facebook creó un comité de personas externas, con gente muy reconocida, para que analicen casos muy complejos que les llegan. No es que no haya una preocupación. Pero también ocurre que se filtra información que muestra cómo las redes, particularmente Facebook e Instagram, viralizan algunos discursos que son nocivos solo por el hecho de mantenerte dentro de la red, que es la estrategia comercial”, dice.

Y sigue: “Ayer me apareció por primera vez en Instagram una sugerencia respecto a la difusión de mensajes violentos y odiantes, para que prestáramos atención. Es la primera vez que veo algún tipo de advertencia en Instagram o Facebook sobre este tema, como hace Twitter cuando querés retwittear una noticia y te pregunta si la leíste. Otra de las cosas que hace Twitter es que cuando detecta que tenés un ataque (por la cantidad de respuestas en muy poco tiempo), automáticamente te ofrece el bloqueo. Me parece que son buenas estrategias de las redes. Deberían hacer más cosas.

Pero está bueno que pongan a circular una especie de legitimación acerca de que no quiere discursos violentos. Por más que no puedan controlar todos los casos”.

Daniele Kleiner, gerenta de Bienestar y Seguridad de Meta (el nuevo nombre de la empresa propietaria de Facebook, Instagram, WhatsApp y Messenger) en América Latina dice que “la seguridad de las mujeres es superprioritaria” para la compañía. Por eso, tal como señaló Chaher, se armó un equipo integrado por doce mujeres expertas en violencia de género, externas a la empresa, que brinda asesoramiento y orientación acerca de cómo mejorar la plataforma en este sentido. La primera medida tomada recientemente como resultado de ese trabajo conjunto es la ampliación de la política de casos de ataques masivos. “Es la situación en la que una persona empieza a recibir muchos mensajes, no necesariamente de contenido violento. La acción de respuesta masiva, sea en un chat privado o en sus publicaciones, se considera bajo esta política”, explica.

Kleiner también menciona otras políticas de Meta que buscan evitar comportamientos intimidatorios: “No permitimos amenazas. También hay una prevención específica para términos ofensivos que tienen que ver con género. Siempre estamos buscando mejorar la aplicación, principalmente con foco en las mujeres, en cómo este tipo de violencia se manifiesta en nuestras plataformas”.

Para combatir los discursos de odio, por ejemplo, Meta lanzó en Instagram una “herramienta de prevención de comentarios ofensivos y bullying”.

Consiste en detectar determinadas palabras que por lo general son reportadas como ofensivas, en el momento en que una persona las está escribiendo en un comentario por publicar. De inmediato esa persona recibe un mensaje que le advierte que el comentario que está por lanzar contiene palabras ofensivas que pueden dañar a alguien y que además violan las políticas de la plataforma. Y un enlace por si quiere profundizar sobre el tema.

“Aplicamos esto porque vimos en estudios internos que cuando la gente es impactada con este tipo de aviso educativo suele reescribir el comentario, en la mayoría de los casos, y publicarlo de una manera mucho más respetuosa. Ahora, si la persona elige igualmente publicarlo así, tenemos una gradación de la penalización, para educar: por ejemplo, suspender la cuenta por unos días o dejarla solo para que la persona pueda ver contenido pero no pueda escribir ningún comentario por algunos días, hay varias opciones a aplicar, para que la persona pueda comprender. Si hay reiteradas violaciones a las políticas por parte de la misma cuenta y esa persona no está dispuesta a tener un comportamiento más respetuoso, podemos considerar algo un poco más drástico”, explica Kleiner.

Aunque varíen los protocolos y las penalizaciones según los casos, las plataformas de Meta siempre remueven los contenidos ofensivos, asegura. “Las penalizaciones tienen una gradación según la gravedad de la violación de la política. Por ejemplo: en el caso de que se compartan imágenes íntimas, si es en una situación maliciosa, vamos incluso a remover el perfil definitivamente de nuestros servicios. Si es una situación de bullying, por ejemplo, la idea es que también podamos utilizar la gradación de las penas para educar. Hay que dar a las personas la chance de aprender que los comentarios ofensivos no son bienvenidos en las plataformas de Meta”.

TAMBIÉN PODÉS LEER

Proteger imágenes íntimas

Otra de las medidas, quizás la más novedosa, que acaba de anunciar Meta, es la ampliación de un proyecto en el cual trabaja desde 2017 para combatir la difusión no consentida de material íntimo: el banco de “hash”. Una suerte de huella digital única que se genera a partir de cada imagen, video o contenido que se publica sin consentimiento para evitar que alguien más lo vuelva a subir.

“Imaginemos que una persona publica material íntimo de alguien. Llegamos a ese material porque alguien denunció o mediante tecnología de detección proactiva de desnudez. Lo removemos para que la gente no tenga más acceso, pero también hacemos lo que llamamos el hash, que es una secuencia única (un código alfanumérico) que representa la imagen. Guardamos el hash en nuestro sistema y borramos el material íntimo. Con las hash podemos identificar si alguien más intenta subir este mismo material y evitarlo”, detalla Kleiner.

Actualmente, Meta se unió a StopNCII.org, una plataforma creada por la organización Revenge Porn Helpline, del Reino Unido, con el fin de expandir el uso de esa tecnología a todas las empresas y organizaciones en el entorno digital que quieran tomar acciones contra la difusión no consensuada de imágenes íntimas en internet (NCII, es su sigla en inglés).

“La idea es que cualquier persona pueda entrar al sitio StopNCII.org y generar esta hash de sus materiales. Por ejemplo, si está sufriendo una amenaza o tiene miedo de que otra persona comparta un material privado. O sea, es una forma de actuar cuando aún no se ha compartido. Puede ingresar a la web y directamente crear un caso”, dice Kleiner.

De esta manera, por iniciativa propia una persona puede crear hash de sus materiales y detectar si alguien quiere publicarlas sin su consentimiento. Para crear las hash en el sitio no hace falta publicar el material en ningún lado, si no que puede hacerse desde los dispositivos de una persona, sin que nadie más tenga acceso.

Demtschenko explica que en la Argentina no existe legislación que proteja contra los abusos en línea. “Lo que existe son leyes que nos protegen contra determinados cyberdelitos. Pero la violencia digital y lo que tiene que ver con el uso y el aprovechamiento de las tecnologías de la información y la comunicación para atentar contra las mujeres, particularmente, no está previsto en ninguna ley”.

“Lo que falta es una reforma del Código Penal que incorpore situaciones que al día de hoy no son delitos y que nos pasan mayoritariamente a las mujeres, aún cuando no somos las únicas víctimas”, dice la abogada. La Fundación Activismo Feminista Digital está impulsando un proyecto de ley para que se incorpore la violencia digital a la Ley de Protección Integral para Prevenir, Sancionar y Erradicar la Violencia hacia las Mujeres, que enumera y describe tipos de violencias y sus modalidades.

“Este proyecto propone que la violencia digital sea contemplada como un tipo de violencia machista y la violencia telemática como una modalidad particular. Una gran parte de los diálogos sobre este tema se enfoca únicamente en que la violencia digital es una modalidad de violencia porque pasa en las redes, en lo virtual. Y es un error técnico muy estudiado por nosotras. Proponemos que la violencia digital sea incorporada como un tipo de violencia machista porque atenta contra los derechos digitales y la telemática como una modalidad porque en el uso de las tecnologías de la información y la comunicación atenta contra derechos ya reconocidos. Esta es la diferencia que creímos fundamental cristalizar. Con esto queremos ampliar derechos y reconocer los derechos digitales”, detalla.

Más allá de los esfuerzos que deben intensificar las redes sociales para combatir la violencia de género y los discursos de odio, y de las normativas que hacen falta para que la virtualidad también se comprenda como un terreno de derechos, tanto Demtschenko como Chaher coinciden en la necesidad de alfabetización digital para todas las personas.

“Debemos empezar a tomar conciencia de que no vamos a las redes como si nada. Una vez, una periodista chilena que entrevistamos para estas investigaciones nos lo dijo de una manera muy clara: si creás una calle le ponés semáforo porque si no, la gente se va a estrellar. Si creás una red social también tenés que poner algunas medidas para que no nos estrellemos.

Quizás no es necesariamente un freno pero tiene que haber algunos recaudos para ver cómo vamos a desarrollar esta comunicación”, dice Chaher.

Demtschenko coincide en que la alfabetización digital es una materia pendiente. “No tenemos una cultura tecnodigital que nos permita dimensionar los efectos de la violencia. Y creo que el quid de la cuestión es cambiar hábitos. Por un lado, pensar en la sobreexposición como un mal de época, que no quiere decir que para no sufrir violencia digital tenemos que evitar expresarnos, sino saber resguardar nuestra información, ser conscientes de estas vulnerabilidades, tener información para decidir y no ir a ciegas. Y por otro lado, apelar a la responsabilidad individual, que en las redes parece que no tiene importancia. Gran parte de los agresores utilizan las plataformas sabiendo que hay impunidad, entonces creo que formar a la sociedad en esta materia es muy importante. La web es un plano de ejercicio de derechos y toda violencia que se ejerza allí va a limitarnos como titulares de derechos”.

***

Esta nota forma parte de la plataforma Soluciones para América Latina, una alianza entre INFOBAE y RED/ACCIÓN, y fue publicada originalmente el 9 de diciembre de 2021.

Podés leer este contenido gracias a cientos de lectores que con su apoyo mensual sostienen nuestro periodismo humano ✊. Bancá un periodismo abierto, participativo y constructivo: sumate como miembro co-responsable.