En esta era de conexiones digitales globales instantáneas, la encarnación actual de noticias falsas se ha convertido en un flagelo que es explotado para obtener rédito político o personal. Y los medios sociales, diseñados para alentar a los usuarios a contribuir y compartir contenidos, se han convertido en los grandes facilitadores de la propagación de fake news.

Según el resultado de una investigación publicada la semana pasada en la influyente revista científica PLOS ONE, se necesita nada más que una pequeña cantidad de noticias falsas para convulsionar cualquier debate o discusión sobre un tema dado. Pero existe una manera para desalentar esas fake news que se propagan y hasta para eliminarlas por completo.

La investigación es experimental, basada en modelos y simulaciones, pero muestra al menos que es posible contrarrestar la proliferación de la información errónea.

El aumento de fake news

La proliferación de información falsa y dañina es algo que ha acosado a las sociedades durante siglos.

Desde países que se inmiscuyen en la política de las democracias y partidos políticos que intentan manipular a la opinión pública a una industria de las noticias falsas centrada en las ganancias, todos han explotado esta propagación por algún provecho, sembrando la confusión y la discordia en las poblaciones víctima que toman como blanco.

El juego de simulación

Hicimos algunos experimentos con el objetivo de comprender los mecanismos más esenciales que determinan la conducta de las fake news in la población.

Específicamente nos interesaban dos cuestiones:

Cuál es el impacto que pueden tener las fake news en la formación de consenso dentro de una población. El impacto del costo de distribución de las fake news en su capacidad para infectar a un grupo poblacional

En el mundo real, los costos pueden ser externos, como las multas, las sanciones, las exclusiones, los gastos para crear y distribuir noticias falsas. O pueden ser internos, como los sentimientos de pérdida o incomodidad debidos a ser ridiculizado o avergonzado.

La herramienta que utilizamos fue una simulación evolutiva, en la que simples robots de software dentro de una población interactúan, jugando el conocido juego Prisoner’s Dilemma. Básicamente, en este juego hay un prisionero que traiciona a otro y gana mucho, mientras que el traicionado pierde fuerte, en tanto que ambos ganan modestamente si cooperan y sufren de igual forma si se traicionan mutuamente.

A diferencia de trabajos previos en este campo, creamos un poco ladinos a estos robots, agregándoles un código que les permitía engañarse entre sí. La víctima de este engaño se confunde con la intención del otro jugador, o está convencida de que el opositor es un “buen tipo” dispuesto a colaborar sin egoísmos.

Nuestro código se basó en nuestros trabajos sobre modelado teórico informativo de los engaños, que permite que los engaños conocidos sean esquematizados bajo la forma de modelos de teoría de juego. Cada uno de los que engañaban en la simulación incurría en un costo cada vez que hacían trampa, que era luego restado del premio que ganaban en el juego Prisoner’s Dilemma.

¿Cuántas fake news se necesitan para afectar el consenso?

Descubrimos que aún un pequeño porcentaje de jugadores tramposos dentro de un grupo poblacional -menos de un 1% en nuestra simulación- era capaz de alterar las conductas de cooperación en la población simulada.

En el caso extremo de los engaños libres de costo -en donde los creadores de fake news no tienen obstáculos- las conductas de cooperación desaparecieron por completo. Sólo cuando el costo de los engaños era mayor que cero sobrevivía la cooperación. Cuando los costos eran muy altos, la cooperación prosperaba de hecho.

Vimos también que en todas las simulaciones, la capacidad de engañar a los jugadores para sobrevivir dependía mucho del costo de los engaños. Si el costo era lo suficientemente alto, los tramposos no podían sobrevivir dentro del grupo.

Si aplicamos esto a la proliferación de las fake news, los costos muy elevados van a conducir a su extinción.

Del experimento al mundo real

¿Qué nos dicen estos resultados experimentales sobre el mundo real de la distribución de fake news entre los medios sociales y la prensa?

El primer resultado, y el discutiblemente más importante, es que se necesitan pocas fake news para crear un caos en una población, y evitar que se cree un consenso, algo esencial para los debates públicos. Si las víctimas están confundidas o creen en falsedades es irrelevante. Lo que se ve afectada es su capacidad para llegar a un consenso.

Nuestros modelos se centraron en pequeños grupos de “influencers” que debaten activamente distintos temas. Allí donde los influencers no se pueden poner de acuerdo, los seguidores a su vez no pueden alinearse detrás de un consenso. Esta es una de las razones por las que las fake news son tan destructivas para las sociedades democráticas.

El segundo resultado de mayor interés es aquel de adosar un costo elevado a la producción, pero, en especial, la distribución de las fake news sería la herramienta más eficaz con la que contamos para derrotar su propagación. Una elevada inversión de parte de la sociedad en lo que tiene que ver con aumentar estos costos bien vale la pena porque los efectos de las fake news son sumamente perturbadores.

Rompiendo la cadena

Hace más de una década, la investigación sobre la guerra de la información descubrió que el delivery de apoderados era un importante multiplicador en la distribución de propaganda tóxica.

Por ejemplo, los medios de prensa que distribuían filmaciones e imágenes violentas producidas por terroristas actuaban como agentes de los terroristas que fabricaban la propaganda, lo supieran o no.

Los usuarios de medios sociales que comparten fake news actúan de igual modo como agentes de los fabricantes de fake news. Esos usuarios son vistos por lo general como víctimas de las fake news -que lo son por lo general-, pero toda vez que comparten fake news se vuelven participantes del engaño del productor de esas fake news.

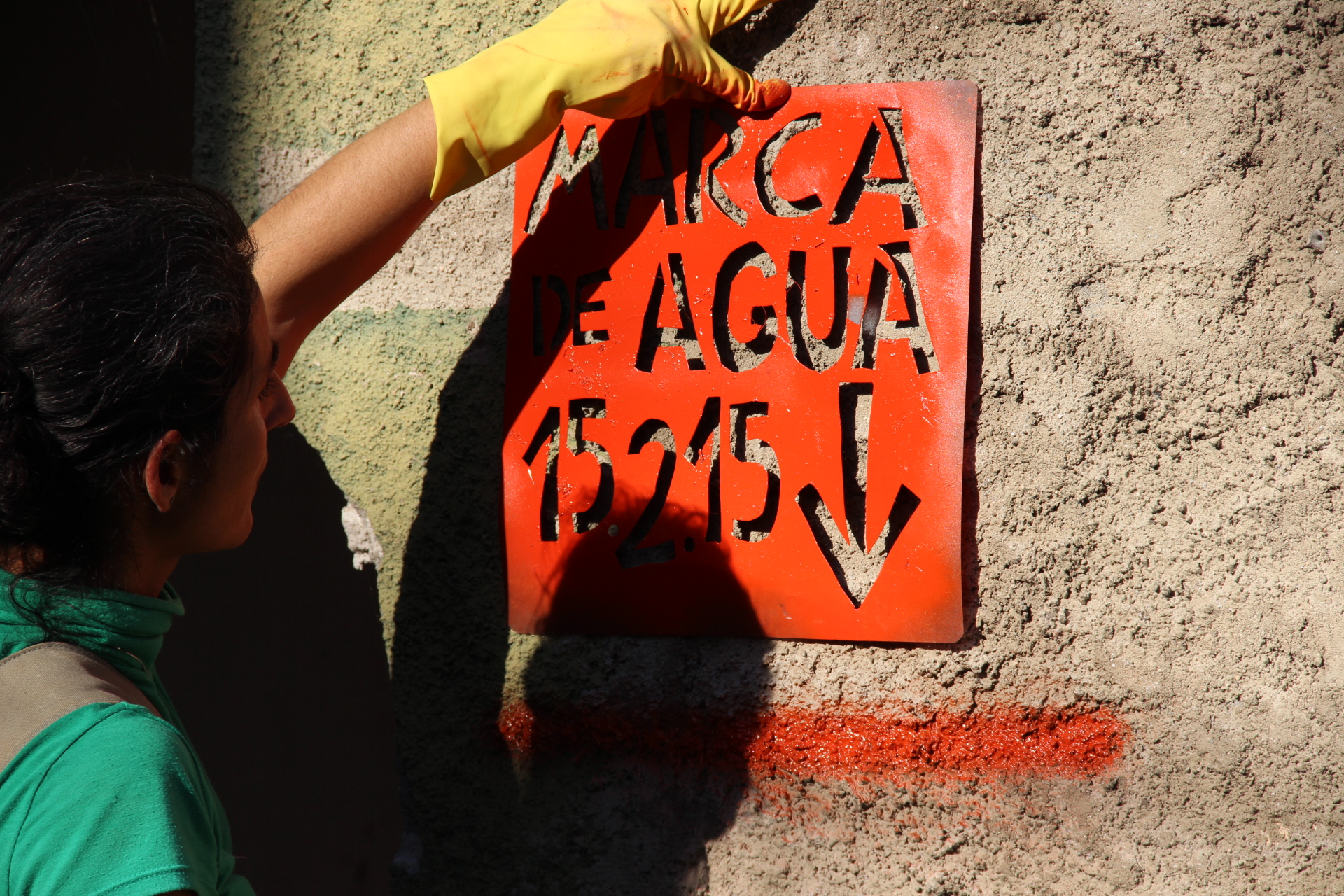

El hecho de asignar un costo a la distribución de las fake news en los medios sociales no es directo. La exhibición informal de afiches generales de fake news es una opción, lo que concuerda con la psicología evolutiva de la detección del tramposo.

Organizaciones de medios sociales como Facebook dicen estar tratando de ser más proactivos en la detección de fake news y noticias falsas ya sea a través de tecnología de aprendizaje con maquinas o detectores de hechos de terceros y dicen haber registrado algunos éxitos recientes.

Pero ambas ideas chocan con el problema más complejo de determinar exactamente qué es, o no es, una fake news. Muchas veces se define como fake news a hechos desagradables.

La objetividad y confiabilidad de los detectores de hechos pueden variar mucho -las verdades en tierra firme se ven oscurecidas muchas veces por prejuicios y limitaciones en la comprensión-.

En este momento, contrariamente a las afirmaciones de los proveedores de medios sociales, la AI no está ocupada en encontrar y desterrar a las fake news, lo que pone la responsabilidad en nosotros los humanos de nuevo.

Todos podemos ayudar simplemente pensando un poco antes de “poner un like”, compartir o escribir un doble tweet en alguna información en los medios sociales. Hagamos tal vez algunas búsquedas para ver si la información se conoce y es tomada como cierta o falsa.

El control de insecticidas es una práctica establecida en los ecosistemas biológicos, y es algo claramente atrasado para el ecosistema informativo.

Por Carlo Kopp y Kevin Korb son acádemicos de la Universidad de Monash

The Conversation ©

Traducción: Silvia S. Simonetti